Дубли страниц. Внутренние дубли страниц – чем опасны, как найти и обезвредить. Как найти дубли страниц: Примеры

Дубль страницы - это еще одна копия страницы сайта, аналогичная по содержанию и наполнению. Выделяют два вида дублей:

- Полный дубликат страницы - когда содержимое полностью идентично;

- Частичный дубликат - когда наполнение страницы по большей степени одинаковое, но имеются отдельные различные элементы.

Почему дубли страниц плохо влияют на ранжирование сайта?

Поисковые системы воспринимают эти страницы, как отдельные страницы сайта, поэтому их наполнение из-за дублирования информации перестает быть уникальным. Кроме того, понижается ссылочный вес страницы, если она имеет дубль. Небольшое количество дублированных страниц может не стать большой проблемой, однако если их более 50% - вам срочно нужно исправлять ситуацию.

Откуда берутся дубли?

Самая распространенная причина - это генерация дублей страниц системой управления из-за неправильных настроек. Самый известный пример - CMS Joomla, с проблемой дублей на ней приходится сталкиваться чуть ли не на каждом сайте.

Частичные дубли часто встречаются на сайтах интернет-магазинов:

- Они могут появляться на страницах пагинации, если те содержат одинаковый текст, изменяя лишь товары;

- Неправильные настройки фильтра по каталогу могут порождать частичные и полные дубли;

- Страницы карточек товаров могут стать дубликатами, если товар, к примеру, отличается лишь цветом или размером (для таких товаров нужно делать одну карточку с указанием всех характеристик).

Как найти дубли страниц?

Есть несколько способов поиска дубликатов страниц, каждый из которых может дать разные результаты.

1. Некоторые распространенные варианты дублей можно проверить вручную.

- Настроено ли главное зеркало сайта (доступен ли он с www и без www);

- Имеются ли нечеткие дубли со / и без / на конце url;

- Наличие дублей с index.html, index.asp, index.php в конце url;

- Доступность страницы с буквами как в нижнем, так и в верхнем регистре, также порождает дубли.

2. Проанализировать страницы, проиндексированные поисковыми системами.

Для этого в Google достаточно ввести запрос site:mysite.com - он покажет страницы общего индекса, то есть все, что поисковик успел проиндексировать на сайте.

3. Поиск по фрагменту текста

Вбивая в поиск длинные фрагменты текста, можно найти места, где он повторяется (а заодно и сайты, которые скопировали ваш текст). Но здесь есть два минуса: метод подходит, если на сайте мало страниц, и то, что поисковая система может анализировать запрос до определенной длины.

4. Заглянуть в панель вебмастера Google

В разделе «Вид в поиске» находим вкладку «оптимизация HTML» и ищем значение поля «Повторяющиеся метаописания» и «Повторяющиеся заголовки». Нажав на них, можно увидеть список всех страниц с повторяющимися тегами title и description и сами заголовки и описания.

5. Воспользоваться программой Xenu`s Link Sleuth

Программа распространяется бесплатно и способна определить url всех страниц сайта, включая скрипты и картинки, а также внешние ссылки. Кроме дубликатов в ней удобно искать битые ссылки - страницы, которые возвращают код 404.

Как устранить дубли страниц?

Для этого существует 4 действенных способа, самыми жесткими из которых. По нашему мнению, являются первые два.

1. Ручное удаление

Это можно сделать на небольших сайтах, хорошенько разобравшись в своей системе управления и сделав правильные настройки, чтобы предотвратить последующее появление дубликатов страниц.

2. Настройка 301 редиректа

301 редирект - это постоянное перенаправление пользователей с одной страницы на другую, что приводит к их склеиванию. Он позволяет передать странице до 99% ссылочного веса, как внутреннего, так и внешнего.

По поводу использования 301 редиректа написаны целые мануалы. Поэтому здесь мы вкратце приведем самые нужные для устранения дублей. Настраивается он либо через файл.htaccess в корневой директории сайта, либо через программный код.

Чтобы настроить главное зеркало, необходимо прописать следующий код:

1 - для редиректа с www на без www

Чтобы склеить нечеткие дубли со / и без него, воспользуйтесь кодом:

1 - убрать слэш

Постраничный редирект выглядит так:

| Redirect 301 /oldpage.html http://www.site.com/newpage.html |

Для формирования более сложных редиректов потребуется воспользоваться правилами. Существуют специальные сервисы, где можно сгенерировать код для настройки редиректа по определенному шаблону:

3. Использовать Rel=”Canonical”

Этот вариант лучше использовать в случае частичных дублей, так как неканоническая страница при этом не удаляется физически с сайта и доступна пользователям.

Для того, чтобы настроить канонические url , в коде страниц в блоке head прописывается ссылка:

«link rel="canonical" href="http://site.com/kopiya"/»

4. Настройка Robots.txt

Также действенный способ, но удалить уже проиндексированные дубликаты таким образом будет сложно.

С помощью директивы Disallow указываются все адреса и их типы, на которые роботам поисковых систем не стоит заходить для индексации. Например:

User-agent: Yandex

Disallow: /index*

Говорит о том, что поисковому боту Яндекс не стоит заходить на страницы, url которых содержит index.

Найти и устранить все дубликаты - основная задача на первых этапах продвижения сайта, иначе можно взяться просто не за те страницы, и долго искать проблему.

Одна из основных причин, по которой сайт может терять позиции и трафик - возрастающее количество дублей страниц на сайте. Они могут возникать в результате особенностей работы CMS (движка), желании получить максимум трафика из поиска за счет шаблонного увеличения количества страниц на сайте, а также из-за сознательного или несознательного размещения ссылок третьими лицами на ваши дубли с других ресурсов.

Проблема дублей очень тесно перекликается с проблемой поиска канонического адреса страницы поисковым анализатором. В ряде случаев робот может определить канонический адрес, например, если в динамическом URL был изменен порядок параметров:

?&cat=10 &product=25

По сути, это та же страница, что и

Product=25 &cat=10

Но в большинстве случаев, особенно при использовании , каноническую страницу определить сложно, поэтому, полные и частичные дубли попадают в индекс.

Что интересно, для Яндекса дубли не так страшны, и даже на страницы результатов поиска по сайту (которые являются частичными дублями друг друга) он может приносить хороший трафик, но вот Google к дублям относится более критично (из-за борьбы с MFA и шаблонными сайтами).

Основные методы поиска дублей на сайте

Ниже описаны основные методы, с помощью которых можно быстро найти дубли страниц своего сайта. Используйте их периодически.

1. Гугл-вебмастер

Зайдите в панель Google для вебмастеров. Найдите раздел меню «Оптимизация» – «Оптимизация HTML». На этой странице можно увидеть количество повторяющихся мета-описаний и заголовков TITLE .

Таким способом можно найти полные копии страниц, но к сожалению, не определить частичные дубли, которые имеют уникальные, однако, шаблонные заголовки.

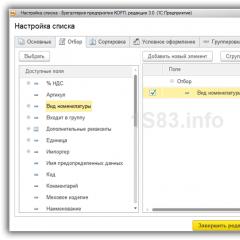

2. Программа Xenu

Xenu Link Sleuth - одна из популярных программ оптимизаторов, которая помогает проводить технический аудит сайта и, в том числе, находить дублирующиеся заголовки (если, например, у вас нет доступа к Google-Вебмастеру).

Подробней об этой программе написано в обзорной статье . Просто просканируйте сайт, отсортируйте результаты по заголовку и ищите визуальные совпадения заголовков. При всем удобстве, данный способ имеет тот же недостаток - нет возможности найти частичные дубли страниц.

3. Поисковая выдача

Результаты поиска могут отразить не только сам сайт, а также некое отношение поисковой системы к нему. Для поиска дублей в Google можно воспользоваться специальным запросом.

site:mysite.ru -site:mysite.ru/&

Где составляющими являются:

site:mysite.ru - показывает страницы сайта mysite.ru, находящиеся в индексе Google (общий индекс).

site:mysite.ru/& - показывает страницы сайта mysite.ru, участвующие в поиске (основной индекс).

Таким образом, можно определить малоинформативные страницы и частичные дубли, которые не участвуют в поиске и могут мешать страницам из основного индекса ранжироваться выше. При поиске обязательно кликните по ссылке «повторить поиск, включив упущенные результаты», если результатов было мало, чтобы видеть более объективную картину (см. пример site: drezex.com .ua -site:drezex.com.ua/&).

Теперь, когда вы нашли все дубли страниц, можете их смело удалять, откорректировав движок сайта или добавив тег в заголовки страниц.

Сегодня мы будем говорить о дублировании контента, а точнее о методах поисках дублей страниц на вашем ресурсе. Проблема дублирования в современном интернете стоит остро, так как если у вас имеются дубли страниц на сайте, вы можете попасть под санкции поисковых систем.

И так первое, что нам необходимо знать это “что такое дублирование контента (дубли страниц) ” и какие бывают их виды, а потом мы уже будем искать пути борьбы с ними.

Дублирование контента – это отображение одного и того же текста на разных страницах сайта (на разных адресах). Дубли страниц на сайте бывают двух видов:

- Полные дубли;

- Неполные (частичные) дубли;

Полные дубли – это когда одна страница, в полной мере отображает содержимое другой и при этом имеет другой адрес.?&cat=10&product=25 и https://сайт/?product=25&cat=10

Неполные дубли – это частичное отображение текста страницы на другой. Это например новостная лента в блогах или текст в сайдбарах. Наиболее часто они встречаются в интернет-магазинах и сайтах где публикуются анонсы, новости.

Как определить дубли страницы на сайте.

Ниже я приведу методы которые используются для определения дублей. Ничего сложного здесь нету, только необходимо немного времени и терпения.

- Поисковая выдача Yandex;

- Поисковая выдача Google;

- Страница открывается со слешем “/” и без;

- Страница открывается с www и без www;

1. Начинаем с первого метода, переходим в аккаунт Google–вебмастер. Дальше переходим на вкладку “Вид в поиске либо Оптимизаци ” и выбираем “Оптимизация HTML ”. На этой странице можно найти и посмотреть все похожие мета-описания и заголовки title.

Google Webmaster определяем дубли страниц на сайте.

Этот метод отлично подойдет для определения полных дублей, частичные дубли с помощью этого метода определить не возможно.

2. Далее рассматриваем как можно определить дубли с помощь поисковой выдачи Yandex. Переходим в поисковую систему и вводим часть текста, при этом обворачиваем его в “кавычки” для того что бы получить точное вхождение фразы.

Yandex — проверяем дубли страниц

Yandex — проверяем дубли страниц Если в выдаче появилась только одна страница оригинал, это отлично – значит дублей нету, если же появилось пару страниц, значит имеются дубли которые необходимо удалить.

3. С помощью поисковой системы Google, определять дубли страниц на сайте, можно также, как и в Yandex. Только при этом необходимо в поисковую строку ввести запрос site:moysite.ru -site:moysite.ru/&, где фразу moysite.ru, заменяем на адрес своего сайта. Если в выдаче нашло только один ваш сайт значит дублей нету, если несколько, необходимо предпринимать меры борьбы с дублированием.

4. Дублирование также может бить если вы используете . Система может генерировать автоматические ссылки которые будут открываться как со слешем “/” так и без.?&cat=10&product=25, вы можете проверить открывается ли этот адрес со слешем в конце “/” https://сайт/?&cat=10&product=25/. Если открывается и не перенаправляет () на выше приведенную страницу, то это дубль страница. Если перенаправляет все работает нормально и можно не беспокоится.

5. Определяем зеркала главной страницы сайта. Аналогично выше описанному методу, пробуем добавлять www или убирать спереди адреса сайта. Если заходит и по одному и по другому адресу, то у вас имеются дубли главной страницы и необходимо их склеить и выбрать главное зеркало сайта.

Ищите дублируемый контент на своем ресурсе, так как это может привести к плохим последствиям. Если Яндекс еще более лояльно относится к дублям, то Google очень сильно наказывает за это и накладывает . Дубли страниц это грубо говоря мусор интернета, а поисковые системы не любят мусор так как он кушает много ресурсов. Поэтому советую устранять эти проблемы еще до индексации статьи поисковой системой.

а если дубль по контенту, а урл другой, стоит каноникал и в робтсе закрыт, но страница в индексе, как это расценивать?

Каноникал решает проблему с дублированием.

Но если страница попала в индекс, а потом ее в robots.txt закрыли, то робот не может просканировать ее еще раз и пересчитать параметры.

Согласен с предыдущим ответом. Решить проблему можно послав запрос на удаление в поисковой консоли.

Maksim Gordienko

Почему для страниц пагинации рекомендуется использовать canonical, вместо удаления текста + noindex, follow + дописывание в начале Title конструкции "Страница N" на второй и последующих страницах пагинации (а можно еще и prev / next добавить)? Сталкивался с тем, что при размещении canonical товары со второй и последующих страниц плохо индексировались.

Была ли практика использования HTTP-заголовка X-Robots-Tag для запрета индексации страниц, так как при использовании robots часто всплывают такие страницы: http://my.jetscreenshot.com... ?

Каноникал - это всего лишь рекомендация. Еще можно использовать 301-редирект для релевантных страниц. По программам для поиска дублей - рекомендую Компарсер + показывает структуру сайта и еще несколько полезных фич есть. Серпстат - дорогой.

Используй лучше каноникал и прев-нектс и будет супер.

Maksim Gordienko

Сеопрофи, например, пишет что каноникал на пагинации имеет смысл ставить только если есть страница "показать все товары" (да и в рекомендациях Google не приводится пример с пагинацией в её классическом виде). А так, товары (содержимое) на второй странице отличается от первой, ставить каноникал нелогично.

Если нужно только дубли проверить, то лучше использовать специфический софт. Советую Netpeak Spider. Он сейчас активно развивается и проверяет очень много параметров на сайте https://netpeaksoftware.com... . Мы его постоянно используем в работе.

Serpstat хорош тем, что это платформа со множеством инструментов: аналитика запросов, ссылок, аудит, проверка позиций.

Підкажіть, буд ласка, ми видалили з сайту інтернет-магазину певні категорії, створили нові, в видалених категоріях були товари і ми цим товарам прописали нові категорії - після цього в нас створилися нові сторінки товарів вже де в урл нові категорії і утворилися дублі. Як краще зробити? Зробити урл товару статичним (а не динамічним) і з нових створених сторінок поставити 301 редиректи на старі? (інтернет-магазин існує 6 місяців) чи має змінюватися урл товару якщо змінили категорію? (в структурі урла товару є назва категорії).

1. Щоб уникнути дублювання URL товарів ми зазвичай поміщаємо їх в одну папку /product/, а категорії задаються в меню і хлібних крихтах.

2. Якщо нема можливості так зробити, то виберіть один із варіантів.

2.1. Використовуйте rel canonical на основную сторінку товару. Скоріше всього, в вашому випадку це нова сторінка, тому що нова категорія вказана в URL. Але ви самі вибирайте головну сторінку.

2.2. Використовуйте 301 редирект на головний URL. При цьому на сайті не повинно бути посилань на старі URL, тобто посилань на 301 редирект.

3. URL товарів краще робити статичными або User Friendly.

4. "чи має змінюватися урл товару якщо змінили категорію? (в структурі урла товару є назва категорії)."

Якщо нема можливості не задавати категорію в URL (як в п.1.), то при кожній зміні категорії в URL її теж треба міняти і налаштовувати 301 редирект на нову адресу.

Дякую за таке обширне пояснення)

Подскажите, как избежать дублей контента. Есть 33 позиции однотипного товара https://delivax.com.ua/pack...

Писать к каждому уникальное описание - сложно и вроде как не нужно. Но из-за того, что описание дублируется, из 33 позиций в индексе висит только 5. Стоит ли переживать по этому поводу и что с этим делать?